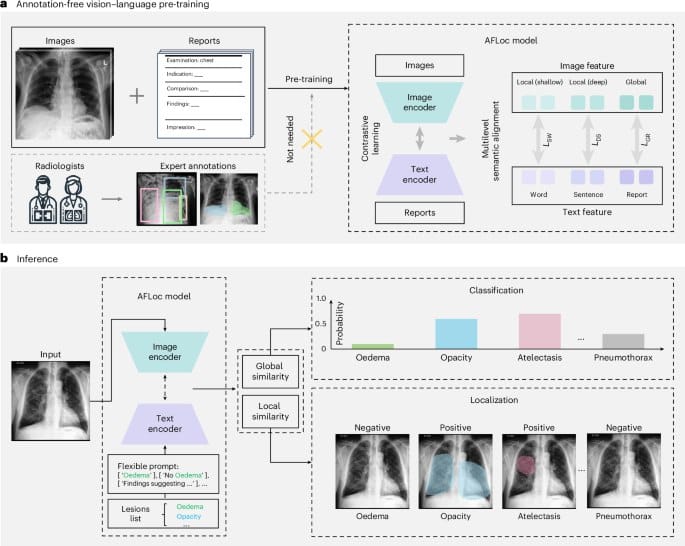

中国团队开发 AFLoc 模型,实现无标注病理定位技术突破

中国科研团队开发出一种名为 AFLoc 的多模态视觉语言模型,可在无需专家标注的情况下实现病理定位。该模型采用多层次语义结构对比学习技术,将多粒度医学概念与丰富的图像特征进行全面对齐,适应病理表达的多样性。

研究团队在包含 22 万对图像报告的胸部 X 光数据集上进行主要实验,并在涵盖 34 种胸部病理的 8 个外部数据集上进行验证。结果显示,AFLoc 在无标注定位和分类任务中均优于现有最先进方法。该模型还在组织病理学和视网膜眼底图像等其他模态上展现出强大的泛化能力,在定位 5 种不同类型病理图像方面甚至超越了人类基准。研究成果已发表在《自然生物医学工程》期刊上。